科学研究

多年来,消息传递范式一直作为图神经网络(GNN)的基础,在广泛的应用中取得了显著的成功。尽管这种范式在多种任务中展示出了巨大的潜力,但它也给图级任务(graph-level tasks)带来了一些意想不到的挑战,如长程问题(long-range problem)、信息瓶颈(information bottleneck)、过度挤压现象(over-squashing phenomenon)和有限的表达能力(limited expressivity)。

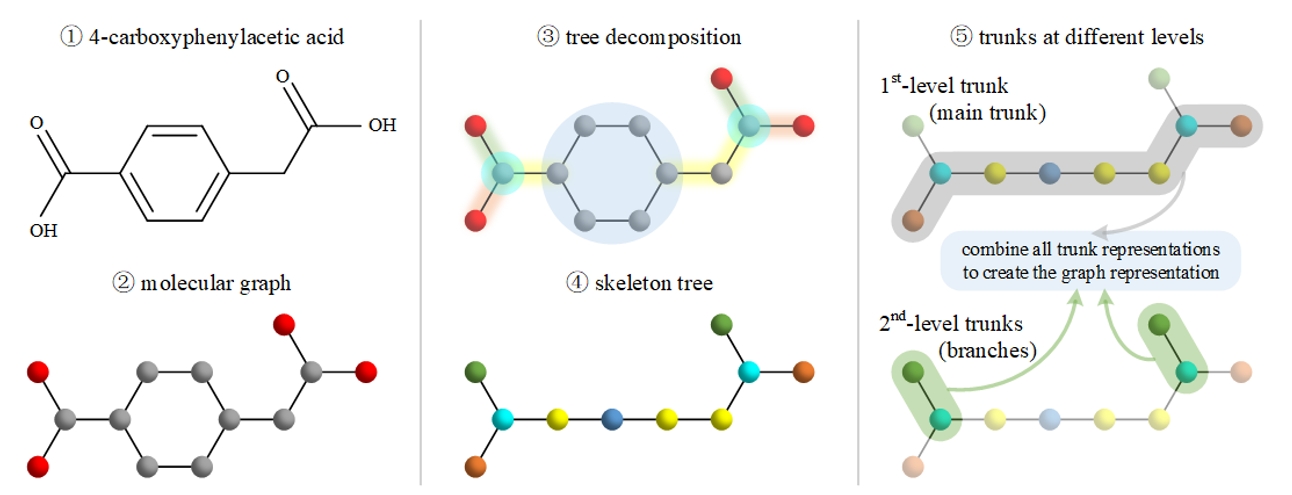

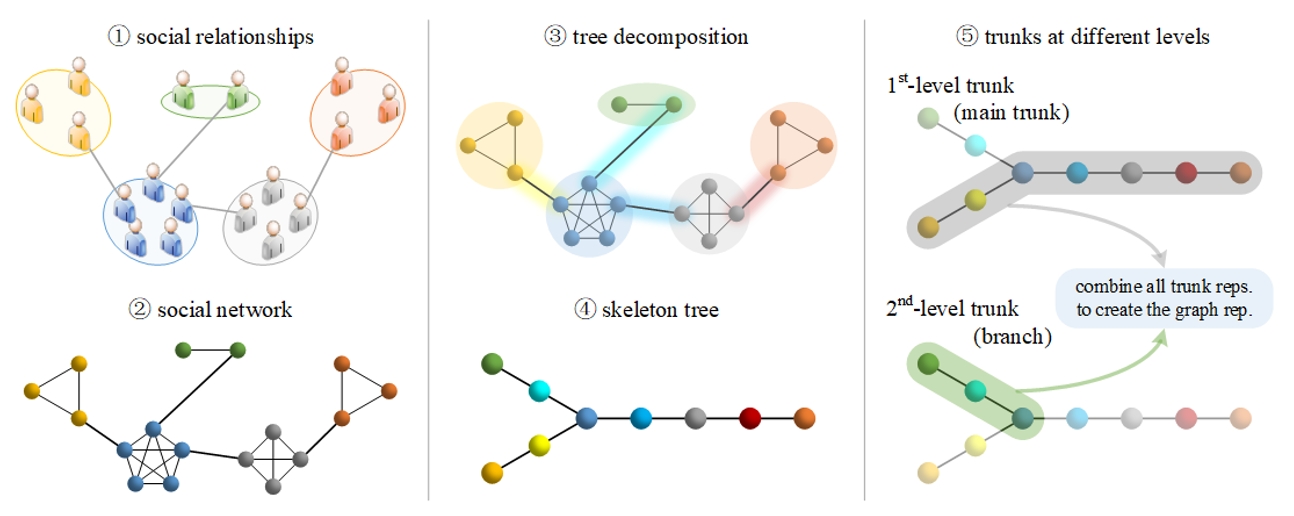

为此,极悦娱乐神经计算与脑机交互团队(NeuBCI)针对图级任务开发了一种新框架——图主干网络(Graph Trunk Network, GTR),目标打破“以结点和边为中心”的传统思维方式,克服传统消息传递范式中的上述挑战。其核心思想在于,图级任务通常不需要像结点级任务那样为每个结点学习极其准确的表示。具体而言,所提出的框架首先使用树分解(tree decomposition)算法从原始图中提取一棵骨架树,随后将骨架树分解为不同级别的主干(亦可形象地称为“树干”),并运用长短期记忆(LSTM)网络沿着主干相应的路径学习各级主干的表示,最后结合各级主干的表示创建原始图的表示。深入的理论分析与全面的实验验证进一步证明了所提出的模型在捕获长程信息和缓解过度挤压问题方面的优越性,从而为图级任务提供了新的见解。

(a) GTR在分子图上的流程示意图

(b) GTR在社交网络上的流程示意图

图1 所提出的模型图主干网络(Graph Trunk Network, GTR)在两类图上的流程示意图。首先(左列),从真实世界场景中提取图数据结构,以构建原始图。其次(中列),使用树分解算法从原始图中提取骨架树。最后(右列),将骨架树分解为不同级别的主干,并结合各级主干的表示创建原始图的表示。

该研究成果已经发表在人工智能领域顶级期刊 IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI),相关代码也已开源。神经计算与脑机交互团队的博士研究生黄中昱为论文第一作者,何晖光研究员为论文通讯作者,康奈尔大学博士研究生王赢珩、微软亚洲研究院李朝卓研究员参与了合作研究。该研究得到了基金委、极悦注册以及CAAI-华为MindSpore学术奖励基金及智能基座等项目的支持。

论文链接:https://ieeexplore.ieee.org/document/10330013

代码链接:https://github.com/zhongyu1998/GTR